Lichtfeldkameras

Trifft Licht auf einen Punkt an der Oberfläche eines Objektes, so wird es in verschiedene Raumrichtungen reflektiert und erzeugt damit ein Lichtfeld. Lichtfeldkameras (auch plenoptische Kameras) liefern neben 2D-Bildinformationen auch die Richtung der an der Abbildung beteiligten Lichtstrahlen.

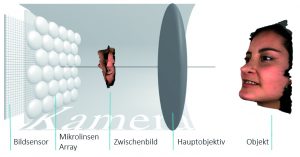

An der optischen Abbildung eines Objektpunktes sind immer Lichtstrahlen aus verschiedenen Richtungen beteiligt. Damit man die Richtungsinformationen des Lichtfeldes nutzen kann, muss die Abbildung des Objektpunktes in vielen Ansichten vorliegen. Realisiert wird dies durch ein Array von Kameras (volle Ortsauflösung, aber hardwareaufwändig) oder ein Mikrolinsen-Array vor dem Bildsensor (weniger Kamerahardware, jedoch verringerte Ortsauflösung). Für Lichtfeldkameras werden aktuell Aufbauten mit Mikrolinsen-Arrays mit verschiedenen Brennweiten (Anordnung in festem Muster) genutzt. Damit ergeben sich, je nach Brennweite, verschiedene scharfe Bildebenen (ca. 100 Ebenen im Jahr 2015). So ist es auch nach der Bildaufnahme möglich, die Tiefe auszuwählen, in dem der Bildinhalt scharf dargestellt wird. Nutzt man zusätzlich das Prinzip der Bildfusion, so können selbst bei großen Abbildungsmaßstäben Bilder extremer Tiefenschärfe erzeugt werden, wie es selbst bei extremer Abblendung nicht möglich wäre. Allerdings müssen dabei die Rohbilddaten bei der Bildfusion aufwändig nachberechnet werden. Für das gesteigert tiefenscharfe Bild muss von Linse zu Linse eine Korrespondenzanalyse aus mehreren Bildern (wie beim fotometrischen Stereo) durchgeführt werden. Dabei wird der Nachteil möglicher Abschattungen (z.B. steile Kanten), wie bei Stereo-Berechnungen mit zwei Kameras, überwunden. Auf diese Weise ist es möglich, neben der 2D-Darstellung auch Tiefendaten aus den Lichtfelddaten zu gewinnen. Dabei ist die Tiefenauflösung (zusätzlich zu den bei fotometrischem Stereo auftretenden Faktoren) abhängig von der Anzahl der Mikrolinsen, sowie der Anzahl der verschiedenen Mikrolinsen-Brennweiten. Ebenso verschlechtert die Perspektive der eingesetzten entozentrischen Objektive die Tiefenauflösung. Durch Berechnung der Rohbilddaten ist es auch möglich, nachträglich den Betrachtungsstandort zu verändern, da das Licht, das von einem Objektpunkt ausgeht, unter verschiedenen Betrachtungswinkeln gesehen wird. Das Prinzip der Lichtfeldkameras kommt bei Zeilen- und Matrixbildsensoren zum Einsatz.