Neue Aufgaben

Multimodal/nicht-linear: Mögliche Erweiterungen des EMVA1288

Wie könnte der EMVA1288 Standard auf neue Modalitäten erweitert werden, z.B. multimodale Bildsensoren oder Bildsensoren nicht-linearer Kennlinie?

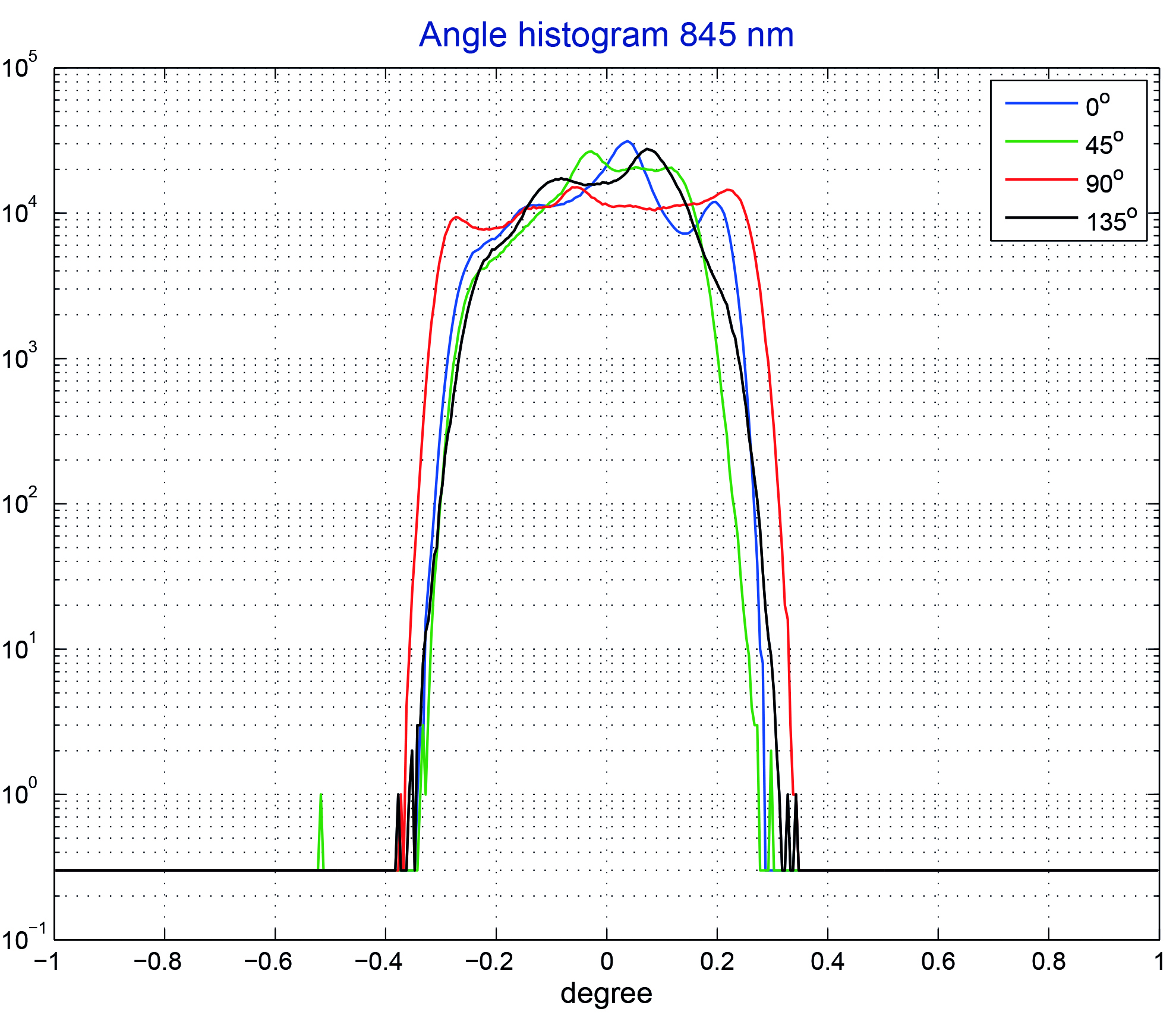

Bild 1 | Logarithmisches Histogramm der Polarisationswinkel der vier verschiedenen linearen Polarisationsfilter auf einem Sony IMX250MZR Sensor (Vorserie).(Bild: HCI Heidelberg Collaboratory for Image Processing)

Bisher umfasst der EMVA1288 Standard nur monochrome und Farbkameras mit einer linearen Kennlinie. Inzwischen kommen aber immer mehr multimodale Bildsensoren auf den Markt, wie z.B. Laufzeitkameras oder andere 3D-Kamerasysteme, multispektrale Bildsensoren mit mehr als drei Farbkanälen, Polarisationsbildsensoren und Kombinationen der genannten Modalitäten. Die Anwendungen von Kameras für Fahrerassistenzsysteme und autonome Fahrzeuge treiben die Entwicklung von Kameras mit einem erweiterten Signalumfang voran, die dann oft eine nicht-lineare Kennlinie aufweisen.

Nicht-lineare Kameras

Eine lineare Kennlinie führt zu einem Kameramodell, das zu einer einfachen Beschreibung der Beziehung zwischen dem Eingangssignal (während der Belichtungszeit auf ein Pixel auftreffende mittlere Anzahl von Photonen) und dem Ausgangssignal (Mittelwert und Varianz des digitalen Kamerassignals) führt. Es werden nur die drei Parameter Varianz des Dunkelrauschens d2, Quantenausbeute und Systemverstärkung K benötigt, um die mittleren Eigenschaften eines Pixels für eine vorgegebene Kameraverstärkung zu beschreiben. Daraus kann die Signalqualität und das Signal/Rausch-Verhältnis (SNR) bestimmt werden. Bei einer Kamera mit einer nicht-linearen Kennlinie ist die Modellbildung schwierig, da man je nach Art der Nicht-Linearität nicht nur ein Modell, sondern viele mögliche Modelle berücksichtigen muss. Daher stellt sich die Frage: Geht es nicht auch ohne Vorgabe eines Modells? Der grundlegende systemtheoretische Ansatz des EMVA1288 mit einer Relation zwischen Eingangs- und Ausgangssignal erlaubt dies. Wie bei einer linearen Kamera werden Mittelwert und Varianz des Ausgangssignals als Funktion der Bestrahlungsstärke vom Dunkelwert bis zur Sättigung gemessen. Mit dieser Messung ohne ein Modell können natürlich Modellparameter der Kamera, insbesondere die Quantenausbeute, nicht bestimmt werden. Aber die Ermittlung der praktisch relevanten Größen ist möglich. Die Empfindlichkeitskurve kann dargestellt werden, die SNR des Ausgangssignals lässt sich bestimmen ebenso wie wichtige abgeleiteten Größen in der Einheit Photonen/Pixel, z.B. die absolute Empfindlichkeitsschwelle, die Sättigungsschwelle und auch der Eingangs-Signalumfang (input dynamic range). Etwas aufwändiger ist allerdings die Behandlung der Inhomogenitäten, d.h. der Variationen von Pixel zu Pixel. Die dark signal nonuniformity (DSNU) kann ähnlich wie bei einer linearen Kamera bestimmt werden. Dagegen ist die Angabe einer photoresponse nonuniformity (PRNU) wie bei einer linearen Kamera aus nur einer Messung bei einer Sättigung von 50% nicht mehr ausreichend. Hier ist eine weitergehende Analyse notwendig.