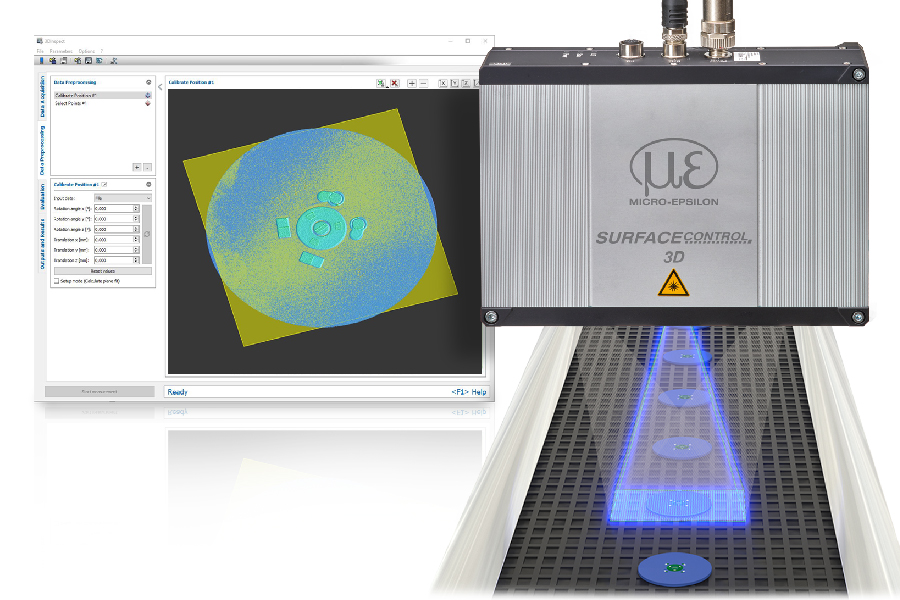

3D im Härtetest

Expertenrunde: 3D-Bildverarbeitungsverfahren im Vergleich

3D-Bildverarbeitung ist mit unterschiedlichen Verfahren möglich. Aber welches System ist das richtige für meine Applikation? Um Licht in den (Verfahrens-)Dschungel zu bringen, fand auf dem ‚View Summit 2015‘, veranstaltet von der Pyramid Computer GmbH, eine Expertenrunde zu diesem Thema statt. Dabei standen drei Firmen mit unterschiedlichen 3D-Verfahren Rede und Antwort. Verglichen wurden Coded-Light und aktive (IR) Stereoskopie (Björn Taubert, Intel), Time-of-Flight (Dr. Robert Hranitzky, Bluetechnix) und Multistereo-RGB (Dr. Gert Ferrano, Matrix Vision).

Könnten Sie die Grundlagen von Structured Light beschreiben?

Björn Taubert: Intel hat bereits 2013 begonnen, die ersten 3D-Kameras an Software-Entwickler zu verteilen. Mittlerweile haben wir zwei Kameratypen im Portfolio. Die eine ist vom User abgewandt (Intel RealSense Camera R200) und in Geräten wie 2in1 und Tablets verbaut. Die andere ist dem User zugewandt (Intel RealSense Camera F200) und kommt in 2in1-Geräten oder in All-in-One PCs zum Einsatz. Die Front-Facing-Kameras funktionieren nach einem Coded-Light-Verfahren – vergleichbar mit dem Structured-Light-Ansatz – bei dem aufgenommene Verzerrungen in dem ausgesandten codierten IR-Licht zur Berechnung der Tiefe genutzt werden. Die Rear-Facing Kameras beruhen auf der IR-Stereoskopie. Sie verarbeiten die RGB- und IR-Daten von zwei Kameras und können so 3D-Daten berechnen. Dieser Prozess läuft übrigens im menschlichen Auge sehr ähnlich ab.

Wie funktioniert Time-of-Flight?

Dr. Robert Hranitzky: Time-of-Flight (ToF) ist eigentlich ein Überbegriff, denn es gibt verschiedene Messverfahren. Auf der einen Seite die Pulslaufzeitmessung, bei der Lichtpulse ausgesendet werden, die von den zu vermessenden Objekten reflektiert werden. Dabei misst man die Zeit, die der Puls braucht, um vom Ziel wieder zurück zur Kamera zu gelangen. Beim PMD-Verfahren verwendet man dagegen eine modulierte Lichtquelle, also Licht mit einer hohen Frequenz von bis zu 50MHz. Es gibt aber auch bereits erste Systeme, die sogar bis 80MHz messen. Dabei wird die Phasenlaufzeit aufgenommen und die Kamera berechnet daraus die Entfernung. Dies erfolgt durch die Aufnahme von Intensitätsbildern, aus denen mittels mathematischer Verfahren zurückgerechnet wird, wie weit das Objekt entfernt ist.