KI-System im Test

Testbericht zum Advantech MIC 730AI Inferenzsystem

Das Advantech MIC 730 AI ist ein KI-Inferenzsystem, das auf dem Nvidia Jetson Xavier basiert. Mit 19x23x9cm hat es die Abmessungen eines Mini-PCs. Die Firma Evotegra konnte das neue System bereits testen.*

Bild 1 | Aufbau des KI-Inferenzsystem MIC 730 AI von Advantech. Die Firma Evotegra hat mit dem System bereits einige Leistungstest vorgenommen*. (Bild: NVIDIA Corporation)

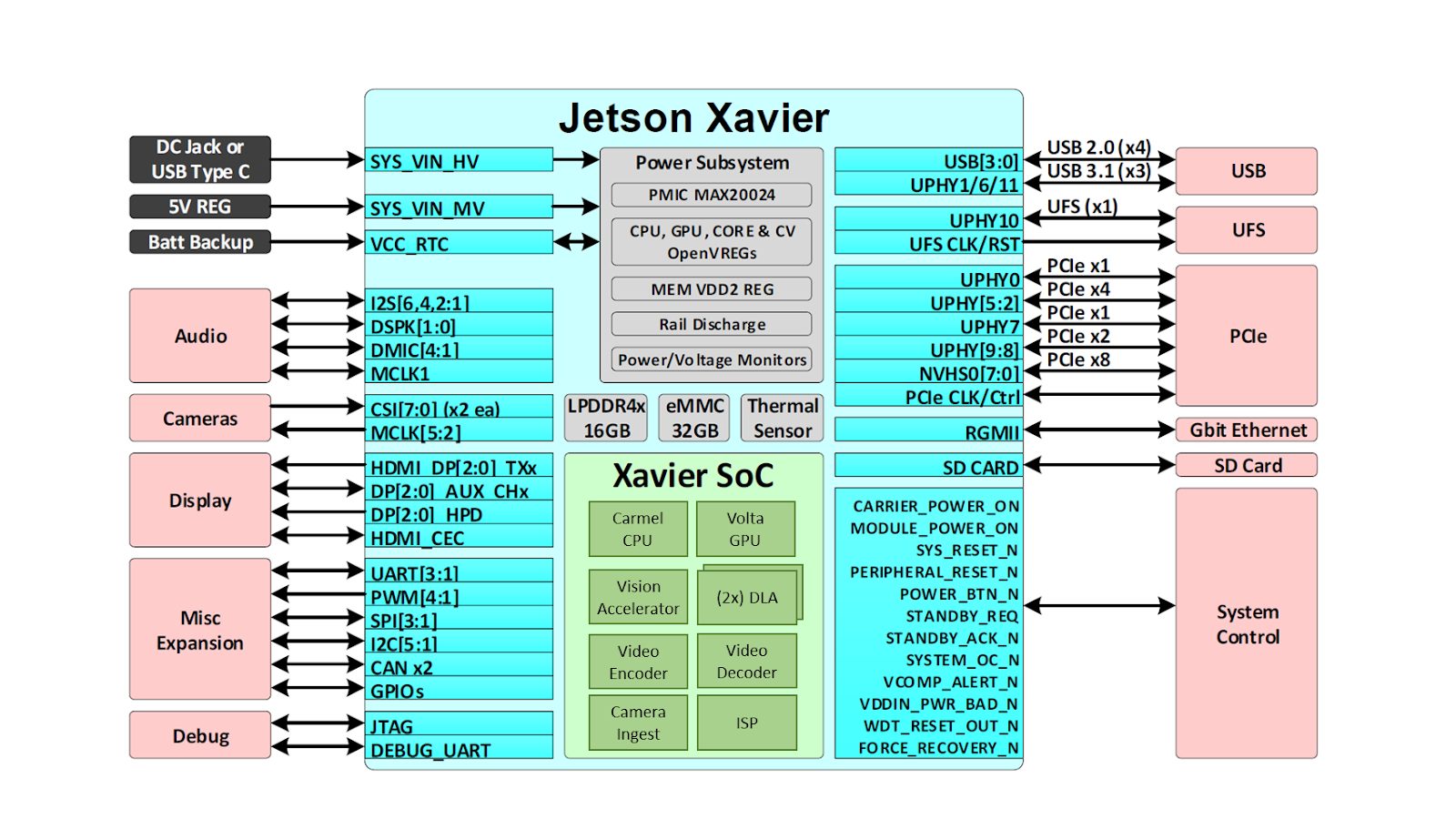

Hauptunterscheidungsmerkmal zu einem herkömmlichen IPCs ist die Tatsache, dass die Jetson-Xavier-Module über eine integrierte GPU verfügen, weshalb das System ausreichend Leistung für die Verarbeitung anspruchsvoller KI-Anwendungen hat. Das Modul ist u.a. mit Video De-/Encoder sowie Deep Learning Beschleunigern (DLA) ausgestattet. Mit einer Betriebstemperatur von -10 bis 50°C, passiver Kühlung und geringem Stromverbrauch ist es für den Edge-Betrieb ausgelegt.

Hardware

Der Jetson Xavier ist in zwei Varianten erhältlich. Die kleinere Version verfügt über 8GB RAM bei einem Speichertakt von 1.333MHz, sechs ARM sowie 364 Volta GPU/48 Tensor-Kernen, während der große Bruder über 16GB bei 2.133MHz Speichertakt und acht ARM sowie 512GPU/64 Tensor-Kerne verfügt. Im Hinblick auf die effektive Leistung für KI-Anwendungen bietet die 16GB-Version ungefähr doppelt so viel Rechenleistung wie die 8GB-Version. Beide Versionen verfügen über 32GB internen Speicher, der neben dem Betriebssystem ca.16GB freien Speicherplatz für zusätzliche Anwendungen bereit hält. Beide Versionen sind mit einem HDMI, 2x RJ45 GbE-Anschlüssen, 2x USB 2.0 sowie 2x USB 3.0-Anschlüssen an der Vorderseite ausgestattet, sowie 2x COM-Ports sowie 16 DI/DO-Anschlüsse. Unter der Rückseite befinden sich weitere 3x USB 2.0-Anschlüsse auf der Platine, ein zusätzlicher COM-Port, eine 5V Stromversorgung sowie ein NanoSim-Slot. Das Gehäuse verfügt über Platz für ein 2,5-Zoll Laufwerk, während das Modul über einen SATA-Anschluss sowie über einen M2 und einen Mini-PCI-Express-Steckplatz verfügt. Für die Unterstützung von zwei PCI-Express-Karten in voller Größe kann das Gehäuse mit dem Erweiterungsmodul MIC-75M20 ausgestattet werden. Über die iDoor Blende kann das System auch mit einer Vielzahl von Mini-PCIe-basierten Erweiterungen (Wifi, LTE, industrielle Feldbusadapter…) bestückt werden. Das System wird mit Linux Ubuntu 18.04 und dem ‚Jetpack‘ Softwarepaket ausgeliefert. Dieses enthält die Nvidia-Bibliotheken und -Tools zur Beschleunigung von Deep-Learning-Anwendungen. Technisch bietet die Umgebung die gleichen Annehmlichkeiten wie ein GPU-basiertes PC-System. Die Bereitstellung von neuronalen Netzwerken, die auf einem PC oder in der Cloud trainiert wurden, ist daher unkompliziert. Obwohl es technisch möglich ist sogar neuronale Netze auf dem MIC-730AI zu trainieren, ist das System grundsätzlich für die Ausführung ausgelegt. Netzwerke können prinzipiell nativ mit Python ausgeführt werden. Um jedoch die beste Leistung zu erzielen, empfehlen wir C++ in Kombination mit Netzwerkoptimierung zu verwenden. Die Nvidia-Inferenzbibliothek TensorRT ist im Jetpack bereits vorinstalliert.