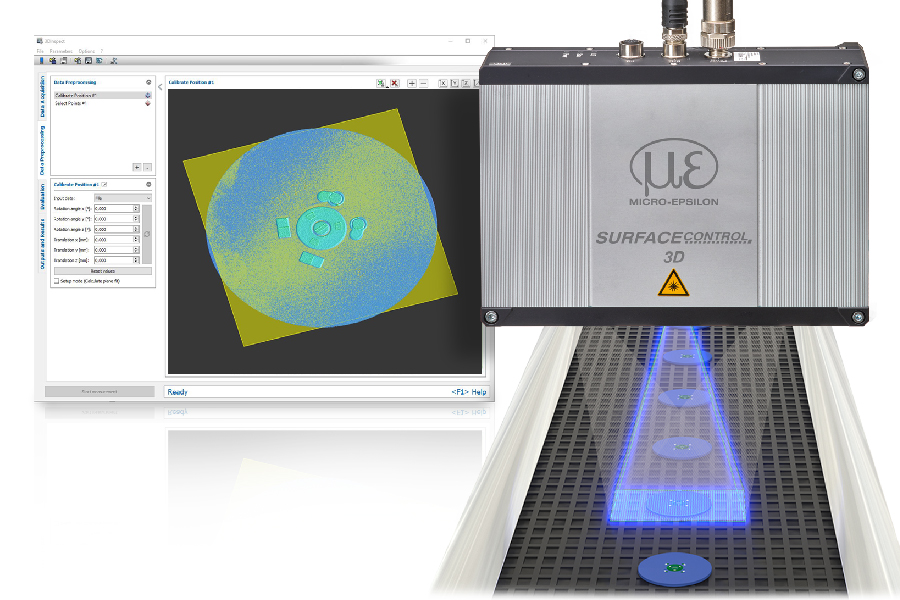

Intelligenter Vision-Sensor vereinfacht bildgeführte Robotik

Mit einem Software-Update für den Vision-Sensor Visor Robotic lassen sich gängige 2D-Anwendungen mit geringem Aufwand in der Robotersteuerung lösen. Ein 3D-Detektor ermöglicht zudem eine Lageerfassung von Objekten in 3D-Koordinaten. Alle Funktionen sind unabhängig vom eingesetzten Robotersystem.

Mit dem aktuellen Software-Release 2.2 bietet der Visor Robotic einen erweiterten Funktionsumfang, wodurch sich Einrichtungsschritte von der Robotersteuerung in die Sensorkonfiguration verlagern lassen. Die neuen Kalibriermethoden geben dem Anwender mehr Freiheit bei der Einrichtung seiner Applikation. Somit kann er in wenigen Schritten einen Abgleich zwischen der vom Sensor erfassten Objektposition und dem Greifpunkt des Roboters durchführen. Die Hand-Eye-Kalibrierung kommt zum Einsatz, wenn der Sensor am Roboterarm montiert ist. Im Unterschied zu klassischen Kalibriermethoden müssen das Sichtfeld des Sensors beim Kalibrieren und der spätere Arbeitsbereich des Roboters nicht identisch sein. Über einen Trigger kann der Anwender die aktuelle Position des Roboters an den Visor senden. Dies ist nützlich, wenn die räumlichen Gegebenheiten ein Ablegen der Kalibrierplatte nicht zulassen. Die zweite Kalibriermethode Base-Eye eignet sich für Anwendungen, bei denen der Vision Sensor stationär montiert ist. Hierzu wird jedes Bauteil nach dem Griff in die Kiste kurz vor den Sensor gehalten und so dessen genaue Position erfasst; im nachgelagerten Arbeitsschritt, etwa beim Ablegen des Teils, wird die Greiferposition dann entsprechend korrigiert. Bei beiden Kalibrierverfahren ist kein manuelles Anfahren realer Punkte oder das Greifen von Bauteilen mehr erforderlich. Um das komplette Koordinatensystem mit Bezug zum Tool-Center-Point des Roboters abzubilden, genügt es, mindestens zehn Bilder einer im Sichtfeld des Roboters abgelegten bzw. am Roboterarm angebrachten Kalibrierplatte in verschiedenen Positionen aufzunehmen. Bei Bedarf ist zusätzlich ein Ergebnisoffset möglich, d.h. eine rechnerische Verschiebung der Ergebnispunkte des Vision-Sensors in die gewünschten Arbeitspunkte des Roboters.